Please select your location and preferred language where available.

助力 AI 的存储解决方案

2025 年 3 月 17 日

更新时间:2025 年 12 月 24 日

生成式 AI 的应用正在各行各业迅速普及,凭借自然语言处理和图像生成技术,它正驱动着各个领域的创新突破。面对激烈的竞争,企业必须具备快速高效的数据处理能力,才能让 AI 模型充分挖掘海量数据的价值。数据存储与内存技术对于构建高性能生成式 AI 系统至关重要。铠侠长期致力于通过在闪存、SSD 及相关技术领域的持续研发与行业贡献,推动 AI 技术的进步。

目录

什么是 AI?

AI 是一项使计算机系统能够通过处理海量数据,执行以往只有人类智慧才能胜任务的技术。目前,AI 有两个主要类别,分别是传统 AI(基于特定输入做出响应)和生成式 AI(具备创造新数据的能力)。传统 AI 的设计初衷是执行预设任务,通过对习得的数据进行图像和声音识别与分析,从而预测结果。而生成式 AI,顾名思义是指它能通过深度学习不断自我进化,它甚至能整合未经人工处理的信息和数据,从而自主生成全新的内容。

AI 的运行阶段及其对存储负载的需求

在执行各项功能时,AI 系统通常需要经历数据采集、数据转换、学习训练和推理等多个阶段。每个阶段产生的负载各不相同,并对 GPU、CPU、内存及存储等系统核心组件提出相应的要求。因此,SSD 和 HDD 等核心存储设备必须具备应对这些多样化负载挑战的能力。

数据融合

将海量的原始数据导入存储系统

数据转换

将数据转换成合适的格式,以便进行分析、清洗和验证

存储设备保存处理后的数据,并将其传输至 GPU 服务器。存储设备不仅要具备海量空间,还要拥有高吞吐能力(顺序读取)。

训练/微调

通过 AI 算法处理数据,评估输出结果并不断优化准确度

存储设备保存中间结果并缓存训练数据。定期保存快照,以确保在发生计算错误或系统故障时无需从头开始。由于在截取快照时 GPU 必须暂停任务,因此需要极高的吞吐性能来迅速完成备份。

推理

模型识别新模式并据此推导出 结论

训练完成后新增、更新的数据以及各类高度机密的信息,通常存储在独立的数据库中。存储设备需要具备大容量以及极高的吞吐性能(随机读取)。

铠侠在 AI 技术领域的活动

铠侠多年来一直致力于 AI 领域的研发创新。

1. 基于 AI 的自主化工厂

铠侠的四日市工厂是生产 BiCS FLASH™ 及其他闪存产品的核心基地。作为一座融合了大量前沿制造技术的智能工厂,它能从生产和测试系统中实时采集海量数据,并通过机器学习等 AI 技术进行深度分析, 从而显著提升生产效率。

2 “Memory-Centric AI”(结合检索技术的 AI)的研发

铠侠在构建和评估大语言模型(LLM)与检索技术相结合的系统机制方面,已发表了多项深入的研究成果。

AI 产业与数据存储展望 - 在推理时代最大化生成式 AI 的效能

自 2022 年底问世以来,大语言模型(LLM)便备受全球瞩目。它引发了“大科技公司”(致力于研发革命性技术的巨头)在训练与推理领域的重大变革,推动了生成式 AI 黎明的到来。可以预见,基于 LLM 的服务将深度融入到多元化的商业模式、各行各业以及社会生活的方方面面。

为了进一步提升推理结果的准确性、关联度与及时性,“检索增强生成”(RAG)技术应运而生,旨在将推理任务的效能发挥到极致。

SSD 在生成式 AI 系统中的应用(训练/推理)

数据是任何生成式 AI 系统不可或缺的基石。凭借非易失性、大容量及高读写速度等显著优势,SSD 已成为存储数据的重要载体。随着生成式 AI 在不同阶段的演进,对 SSD 的需求正呈现爆发式增长。预计在 2024 年至 2030 年间,SSD 容量需求市场将大幅增长,增幅约为 40 至 50 倍。

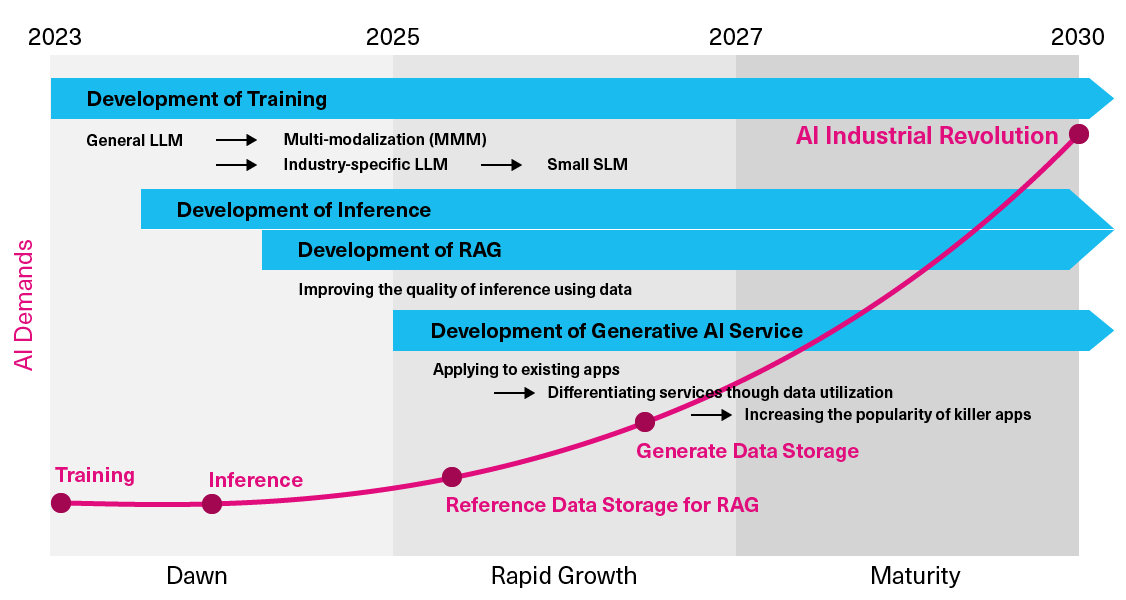

铠侠认为,在迈向 2030 年的中长期展望中,生成式 AI 市场的增长将由以下四大趋势驱动:

- 学习能力的演进

- 推理能力的提升

- 旨在提升推理能力的 RAG 技术的发展

- 生成式 AI 服务的普及

在以上所有趋势中,SSD 都将发挥至关重要的作用。

从硬件角度看 SSD 的优势

在生成式 AI 系统中,训练和推理任务均需消耗昂贵的 GPU 资源。然而,仅依靠易失性的 DRAM 缓存,根本无法处理生成式 AI 流程中产生的海量数据。因此,利用非易失性存储设备来提供训练数据、在推理过程中为 RAG 提供参考数据检索以及保存生成的数据,已成为数据处理中不可或缺的部分。

目前,对存储设备的核心要求是:最大化 GPU 利用率,从而充分释放昂贵 GPU 硬件的计算潜能,同时实现能效与空间效率的最优化。虽然,人们在谈及海量容量时通常首先想到的是 HDD,但受限于盘片旋转延迟和磁头寻道移动等机械特性,HDD 的读写延迟可能比 SSD 高出百倍以上,从而严重拖累整体能效。相比之下,SSD 能够支撑起高性能 AI 存储服务,将 GPU 的处理效率发挥到极致,并能满足未来日益增长的大容量存储需求。

SSD 对于推理需求的优势

目前,已有许多企业通过引入 LLM 来提升运营效率和生产力。

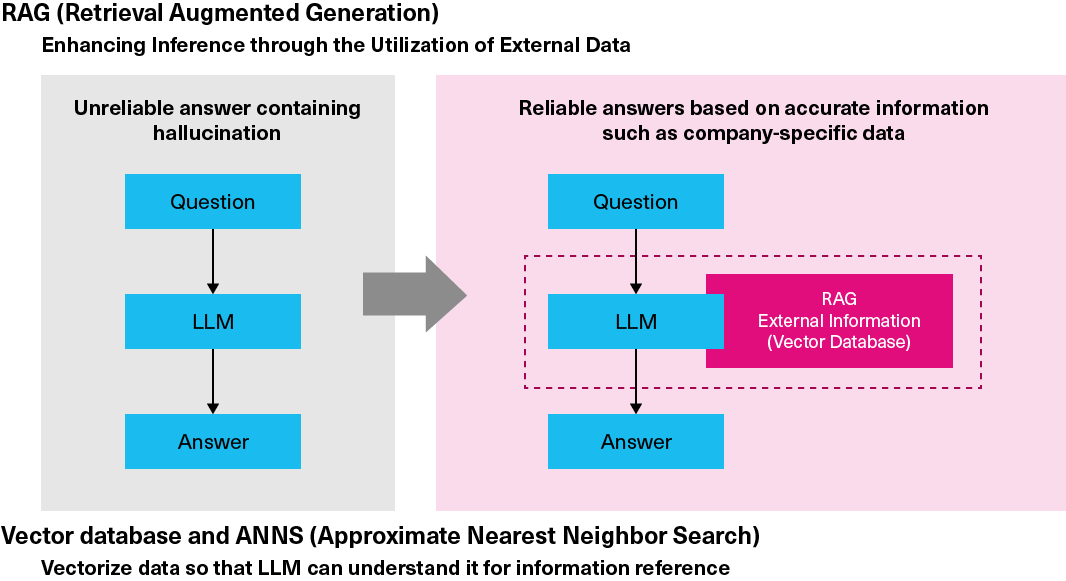

然而,LLM 的知识库仅限于其训练阶段使用的数据集,因此其获取的信息往往具有滞后性。对于需要调取最新信息、企业自有数据或机密信息的指令,过时的 LLM 可能无法生成准确答案。这些偏离事实、甚至南辕北辙的错误结果被称为“幻觉”。

RAG 技术通过将 LLM 外部更准确、更实时的知识以向量数据库的形式进行整合,有效解决了幻觉问题。RAG 利用基于向量相似度检索功能的数据库软件(即向量数据库)调取数据。许多企业对 RAG 兴趣浓厚,正是因为它能通过非公开的信息来增强 LLM 能力,从而大幅提升 AI 输出的准确度。

在 RAG 流程中,定位与查询向量最匹配的向量(并从存储的知识库中调取对应数据),需要对数百乃至数千维度的高维向量进行相似度计算。即便对于最先进的 AI 服务器,这依然是一项极其沉重的计算密集型任务。为解决这一难题,通常采用近似最近邻(ANN)检索技术。该技术通过构建索引来大幅缩小需要比对的向量范围,从而在海量数据中快速找到近似最优解。

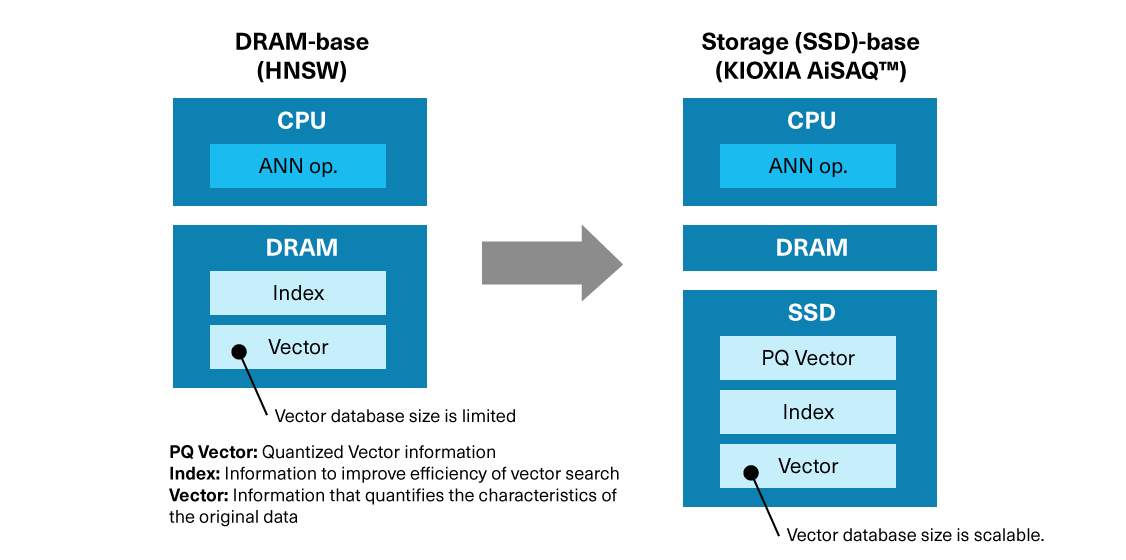

ANN 检索有多种技术路径,包括 DRAM-based HNSW(分层导航小世界算法),以及由微软研发、主要基于存储介质的 DiskANN。目前,将向量及其索引存储在 DRAM 中的 HNSW 算法应用最为广泛。然而,AI 可调取的知识总量(即向量数)往往受限于服务器 DRAM 的容量,因而也限制了构建基于海量知识库的高能效 RAG 系统。

为此,铠侠研发了 KIOXIA AiSAQ™ 软件——一种通过 SSD 进行 ANN 检索的新型存储方案。铠侠将持续致力于这一关键存储技术的研发,在飞速发展的生成式 AI 市场中进一步挖掘 SSD 的潜力。

KIOXIA AiSAQ™ 技术:铠侠的 AI 创新成果

顾名思义,KIOXIA AiSAQ™(基于乘积量化的全存储近似最近邻检索)软件可以将量化后的数据特征信息(PQ 数据)以及所有 ANN 构成要素全部转移至 SSD 中,从而优化 RAG 阶段向量检索环节所需的近似最近邻检索算法。目前,该软件已向市场开源,以推动高质量生成式 AI 应用的诞生。

在传统的 AI 工作流程中,索引数据通常存放在 DRAM 中以确保检索效率。KIOXIA AiSAQ™ 技术则将索引数据直接放置在 SSD 上。

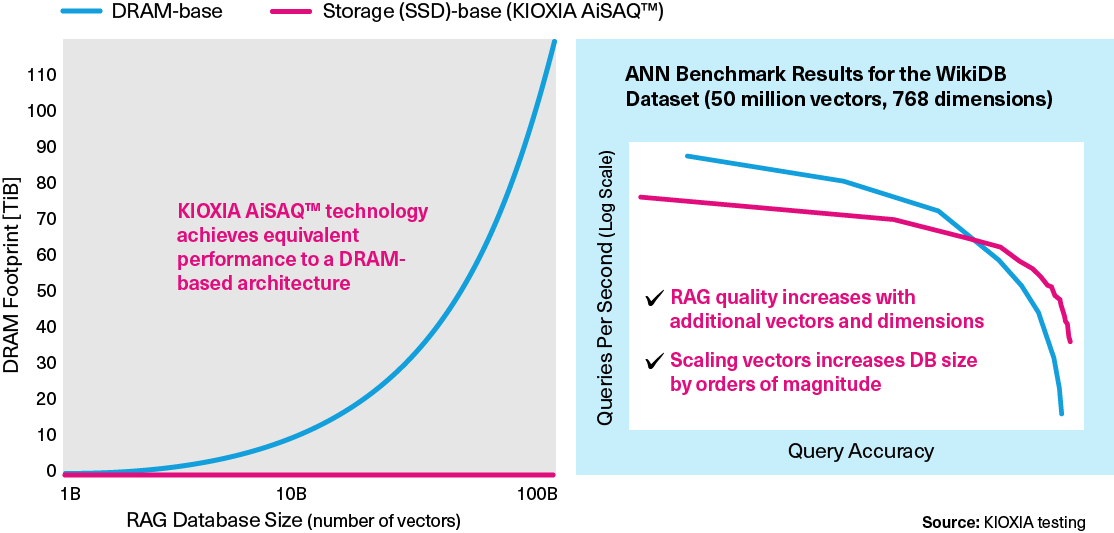

为实现更精准的 AI 查询,RAG 向量数据库需要不断扩大规模。在“基于 DRAM”的方案中,数据库规模扩大将直接导致 DRAM 需求激增(如下面的左图所示)。从实测数据来看,基于 SSD 的检索方案在查询准确度与每秒查询数方面的表现是优于 DRAM 方案的(如下面的右图所示)。

这项创新的 RAG 技术极具应用前景,因为它能在不影响性能的前提下,利用高性价比的 SSD 替代成本高昂的 DRAM,从而显著提升 ANNS 效率。

KIOXIA AiSAQ™ 软件下载

KIOXIA AiSAQ™ 是一款开源软件。请点击下方链接下载。

GitHub:

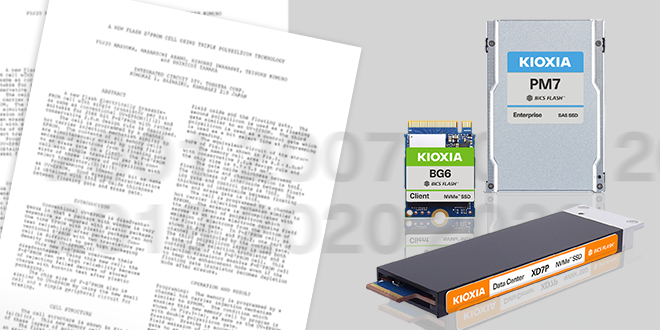

铠侠产品支持 AI 市场

专为 AI 工作负载打造的铠侠企业级与数据中心级 SSD。

- 容量的定义:铠侠株式会社将兆字节(MB)定义为1,000,000字节,将千兆字节(GB)定义为1,000,000,000字节,将太字节(TB)定义为1,000,000,000,000字节。但是计算机操作系统记录存储容量时使用2的幂数进行表示,即定义1GB = 2^30 = 1,073,741,824 字节,因此会出现存储容量变小的情况。可用存储容量(包括各种媒体文件的示例)将根据文件大小、格式、设置、软件和操作系统和/或预安装的软件应用程序、或媒体内容而异。实际格式化的容量可能有所不同。

- NVMe是NVM Express, Inc.在美国和其他国家的注册或未注册商标。

- *PCIe 是 PCI-SIG 的注册商标。

- 其它公司名称、产品名称和服务名称可能是第三方公司的商标。